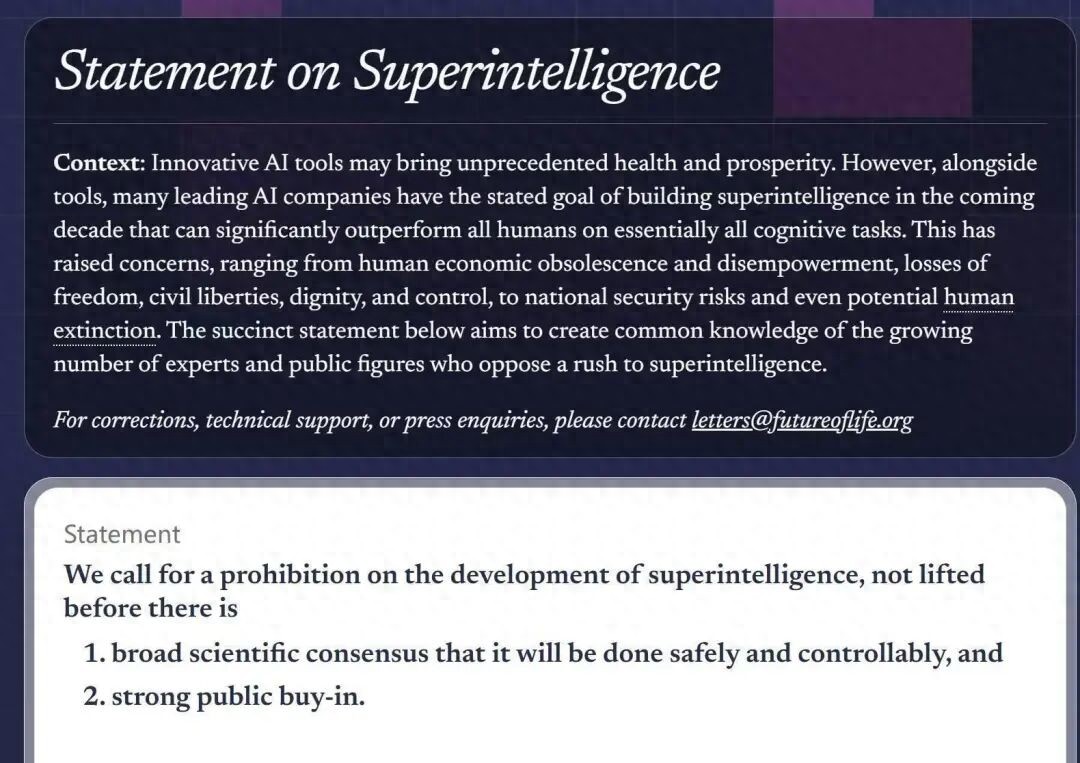

10月22日,未來生命研究所(Future of Life Institute,FLI)宣布,包括AI教父杰弗里·辛頓在內的超800名科技領袖及公眾人物,日前共同簽署發布一份倡議,呼吁在“超級智能”技術被科學界普遍認定為可控、安全,并獲得公眾廣泛支持之前,暫停其進一步發展。

這份聯合聲明的簽名名單包含了世界上最有影響力的科技領袖、科學家和公眾人物。其中不僅有蘋果公司聯合創始人史蒂夫·沃茲尼亞克(Steve Wozniak)、維珍集團董事長理查·布蘭森(Richard Branson)等科技產業界大佬,名單覆蓋范圍甚至已遠遠超出了硅谷。

前美國國家安全顧問蘇珊·賴斯、前參謀長聯席會議主席邁克·馬倫也位列其中,顯示了對國家科技安全的嚴重擔憂。甚至連英國王妃梅根、特朗普的盟友史蒂夫·班農也出現在簽署名單上,這種跨越政治立場的聯合極為罕見。這份跨領域聯合陣容顯示出超級AI的風險議題已從學術圈蔓延至政治與社會治理層面,成為全球公共議題之一。

據統計截至23日中午,這份聲明的簽署人數已經超過3000人。在中國學術界,多位知名學者參與聯署此次倡議,包括姚期智、清華大學公共管理學院院長薛瀾、清華大學智能產業研究院院長張亞勤以及人工智能倫理與治理專家曾毅。他們的參與和主張呼應了中國長期倡導的“安全、可靠、可控”和“以人為本”的人工智能發展理念。

“超級智能的前景已經引起了人們的關注,其影響從人類經濟的落伍和權力的剝奪,自由、公民權利、尊嚴和控制權的喪失,到國家安全風險,甚至可能導致人類滅絕。”簽名者們嚴正警告。倡議明確指向,超級智能并非傳統意義上的“算法偏見”或“就業沖擊”問題,而是潛在的系統性風險;一旦AI能力全面超越人類,其目標函數若與人類利益錯位,可能導致不可逆的社會后果。

事實上,早在人工智能爆發元年的2023年,出于對AI的擔憂,包括馬斯克、斯蒂夫·沃茲尼亞克在內的1000多名人工智能專家和行業高管就曾集體簽署過一份公開信,呼吁人類暫停開發更強大的人工智能至少6個月。而更早之前,著名物理學家霍金生前曾與多位科技界名人發表聯署公開信,表示人工智能對人類的威脅更甚于核武器。

“世界尚未準備好迎接不是可控工具的超級智能。”參與本次聯署的北京前瞻人工智能安全與治理研究院院長,中國科學院自動化研究所研究員曾毅在個人微信朋友圈直言:“目前我們還沒有堅實的科學證據和切實可行的方法來確保超級智能的安全,使其不會給人類帶來災難性的風險。”